NVIDIA DGX Spark – rewolucyjna stacja robocza dla lokalnej sztucznej inteligencji

Przejdź do strony produktowej i sprawdź naszą ofertę!

Kompaktowa moc obliczeniowa nowej generacji

NVIDIA DGX Spark to najbardziej wyczekiwana stacja robocza AI roku - niezwykle kompaktowa, a jednocześnie potężna jednostka stworzona z myślą o lokalnym przetwarzaniu sztucznej inteligencji. Urządzenie oferuje 128 GB pamięci LPDDR5X, 20 rdzeni ARM, zintegrowany procesor graficzny Blackwell GPU oraz dwa porty sieciowe 200 Gb/s RDMA. W praktyce oznacza to, że DGX Spark łączy wydajność klasy serwerowej z mobilnością laptopa - można go dosłownie spakować do plecaka.

Inspiracją dla projektu Spark była legendarna seria DGX-1, znana z centrów danych. Tym razem NVIDIA przeniosła jej filozofię do formatu biurkowego, oferując wszystko, czego potrzeba do tworzenia, trenowania i testowania modeli AI - lokalnie, bez konieczności korzystania z chmury.

Budowa i parametry techniczne

Urządzenie, mimo swoich rozmiarów zbliżonych do komputera typu Mac Mini, znacząco przewyższa go pod względem wydajności. Wewnątrz znajdziemy:

-

Procesor NVIDIA Grace Blackwell (GB10) - połączenie 20-rdzeniowego CPU ARM (10x Cortex X925 + 10x Cortex A725) z GPU Blackwell;

-

GPU klasy RTX 5070, oferujące do 1 PetaFLOPS mocy obliczeniowej dla zadań AI;

-

128 GB zintegrowanej pamięci LPDDR5X, umożliwiającej przetwarzanie dużych modeli językowych i generatywnych;

-

Dysk NVMe 4 TB;

-

Łączność RDMA przez ConnectX-7 (2 × QSFP56, 200 Gb/s);

-

Wi-Fi 7 i Bluetooth 5.3;

-

Zasilanie przez USB-C PD i pobór mocy od 45 do 130 W (do 240 W przy pełnym obciążeniu).

Całość działa pod kontrolą systemu DGX OS, będącego zmodyfikowaną wersją Ubuntu z wbudowanymi sterownikami i oprogramowaniem NVIDII.

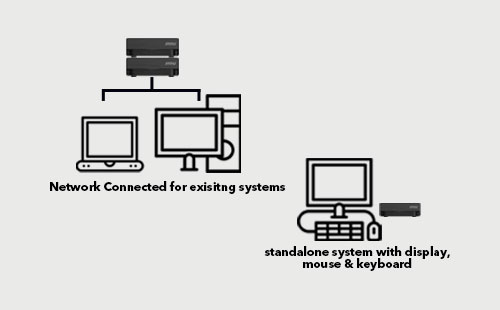

MSI EdgeXpert – przemysłowa stacja AI oparta na technologii NVIDIA DGX Spark

W ofercie Elmark Automatyka znajduje się MSI EdgeXpert – jednostka AI zbudowana w oparciu o technologię NVIDIA DGX Spark.

To rozwiązanie łączy potęgę obliczeniową platformy NVIDIA z niezawodnością i trwałością konstrukcji MSI. EdgeXpert to idealny wybór dla firm, które chcą:

-

rozwijać i testować lokalne modele AI,

-

przetwarzać dane na brzegu sieci (Edge Computing),

-

wdrażać inteligentne algorytmy w fabrykach, laboratoriach, biurach R&D czy systemach wizyjnych.

Urządzenie zachowuje wszystkie zalety oryginalnego DGX Spark – ogromną moc, efektywność energetyczną i możliwość klastrowania, jednocześnie oferując solidną konstrukcję i pełne wsparcie techniczne ze strony Elmark Automatyka. MSI EdgeXpert

MSI EdgeXpert

Cicha praca i niskie zużycie energii

Pomimo swojej mocy, DGX Spark zaskakuje niskim poziomem hałasu - nawet podczas intensywnego obciążenia nie przekracza 40 dBA. Zużycie energii w trybie jałowym wynosi zaledwie ok. 45 W, a podczas testów obciążeniowych urządzenie utrzymywało pobór w granicach 120–130 W, pozostając wyjątkowo ciche.

Skalowalność dzięki RDMA i ConnectX-7

Jedną z największych zalet DGX Spark jest możliwość łączenia wielu jednostek w klaster bez konieczności stosowania dodatkowych przełączników. Dzięki wbudowanej karcie NVIDIA ConnectX-7, dwa urządzenia można połączyć bezpośrednio kablem QSFP56 200 Gb/s i stworzyć wspólną przestrzeń obliczeniową o pojemności 256 GB pamięci i dwóch układach GB10.

Uruchamianie dużych modeli językowych lokalnie, od 200 do 405 miliardów parametrów

- Obsługa modeli AI do 200 miliardów parametrów Uruchamiaj duże modele językowe lokalnie, zachowując bezpieczeństwo danych, niskie opóźnienia i kontrolę kosztów. Pełny proces pracy z AI—od prototypowania, przez dostrajanie, aż po wnioskowanie.

- Łączenie systemów przez NVIDIA ConnectX: większe modele i lepsza wydajność Wysokowydajne rozwiązania sieciowe NVIDIA ConnectX pozwalają połączyć dwa systemy DGX Spark i pracować z modelami AI do 405 miliardów parametrów.

Dla większych konfiguracji można zastosować przełączniki 400 GbE, co pozwala na budowę klastrów składających się z kilkudziesięciu Sparków. To rozwiązanie, które jeszcze niedawno było zarezerwowane dla serwerowni HPC, a teraz mieści się na biurku.

Zastosowania i oprogramowanie

DGX Spark to nie tylko sprzęt — to kompletny ekosystem. NVIDIA udostępnia platformę build.nvidia.com, która zawiera gotowe „receptury” i przewodniki dla twórców AI, m.in. do:

-

uruchamiania LLM (Large Language Models), takich jak Qwen 32B czy GPT-OSS 12B,

-

trenowania modeli obrazowych z użyciem ComfyUI,

-

konfiguracji środowisk VS Code, Cursor AI Workbench, Open WebUI,

-

łączenia wielu jednostek DGX Spark w klaster.

Dzięki dużej ilości pamięci, DGX Spark umożliwia uruchamianie modeli wymagających nawet 60–65 GB VRAM, które nie mieszczą się w typowych kartach GeForce lub Radeon. To ogromny krok naprzód dla programistów, którzy chcą testować lokalne modele bez korzystania z infrastruktury chmurowej.

Dla kogo jest DGX Spark?

Dla deweloperów AI

Idealne środowisko do trenowania, testowania i prototypowania modeli – w pełni kompatybilne z ekosystemem CUDA, PyTorch i TensorFlow.

Dla menedżerów i firm

DGX Spark może stać się narzędziem dla kadry zarządzającej, pozwalającym eksperymentować z agentami AI i automatyzacją procesów bez konieczności inwestowania w drogie serwery. W cenie około 4000 USD, to dostępny punkt wejścia w świat lokalnej sztucznej inteligencji.

Dla mobilnych profesjonalistów

Dzięki kompaktowej obudowie i zasilaniu USB-C, Spark można zabrać w podróż i używać jako mobilnej stacji AI – wystarczy laptop i połączenie zdalne.

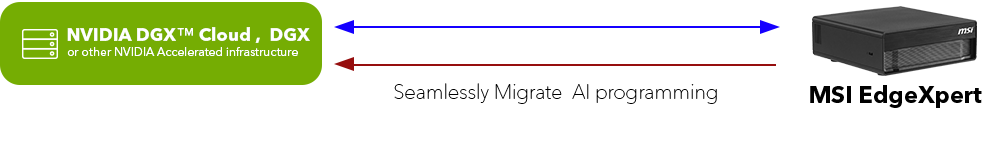

Płynne skalowanie modeli AI z Twojego biurka do chmury

Wykorzystaj architekturę oprogramowania AI od NVIDIA do bezproblemowego skalowania rozwiązań—od komputera na biurku, przez chmurę NVIDIA DGX, po inne centra danych i infrastruktury chmurowe wykorzystujące akceleratory NVIDIA. Wszystko przy minimalnych zmianach w kodzie.

Podsumowanie

NVIDIA DGX Spark to nowa era w dziedzinie lokalnych systemów AI. Łączy moc obliczeniową z miniaturową formą, oferując użytkownikom możliwość pracy z dużymi modelami AI w dowolnym miejscu.

Z perspektywy zarówno inżynierów, jak i firm – to narzędzie przełomowe, które może zdemokratyzować dostęp do zaawansowanych technologii AI i umożliwić szybkie prototypowanie oraz wdrażanie inteligentnych rozwiązań bez potrzeby inwestowania w kosztowną infrastrukturę serwerową.